カレントアウェアネス

No.363 2025年03月20日

CA2079

動向レビュー

生成AIを用いた文献調査ツール

筑波大学図書館情報メディア系:矢田竣太郎(やだしゅんたろう)

1. はじめに

人工知能(AI)技術が人々の生活や日々の業務に取り入れられて久しく、調査や研究の場面でも有用なツールが多数登場している。特に生成AIが登場してから動きは加速しており、図書館関係者でもその語を見聞きしない日がないほどだろうと思われる。本稿では、図書館現場でも使われうる、生成AIを用いた文献調査ツールに着目して、現状と展望を述べる。特に文献調査は研究支援業務で重要なため、大学図書館の文脈に論の重きを置くことにしたい。また、筆者は言語処理技術を主たる手法に据える図書館情報学研究者を自認するとともに、生成AIの実体ないし基盤である大規模言語モデル(LLM)の安全性を検討する研究者グループ(LLM-jp安全性検討ワーキンググループ(1))に所属している。本稿と同じ目的の既報(2)がある中で、本稿は技術と安全の観点を付加できたらと思う。

2. 技術的背景

AI技術そのものは検索エンジンにすら古くから組み込まれており、目新しいものではない。検索キーワードをシステム側で自動で拡張したり(3)、文献とクエリの類似度を生成AI並みの言語モデルで判定したり(4)、文献をさまざまな観点であらかじめラベル付けしておく(5)といった、言語処理ベースの技術の実用には多くの実績があったのである。

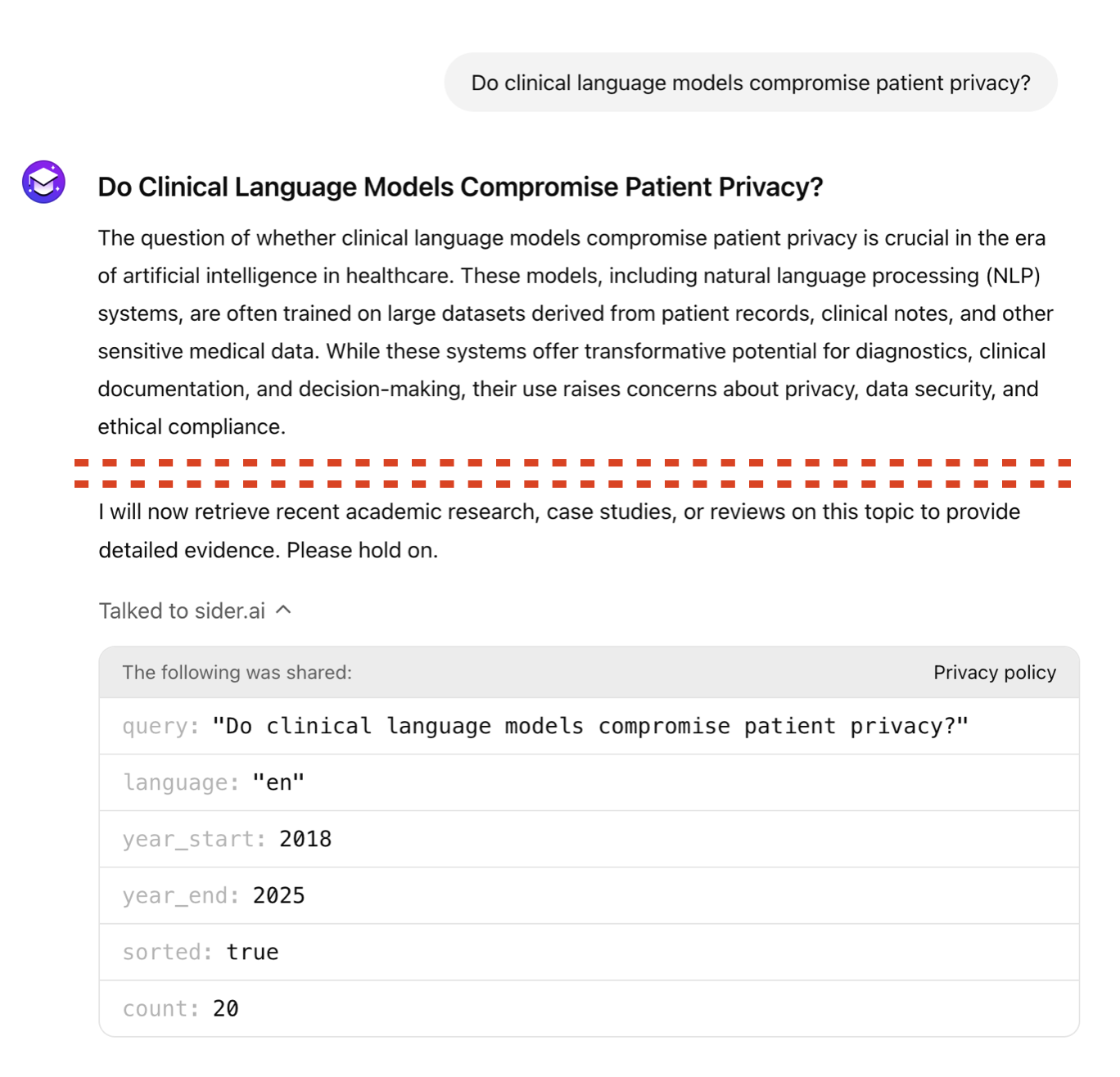

しかし生成AIを用いたものは、今までにないレベルの脚光を浴びているように感じられる。従来技術が文章の類似度判定やラベル付けといった言語理解タスクに基づいていたのに対し、文章そのものを産生する生成AIの採用によって、自然文での対話をユーザインタフェース(UI)にできたことが、その大きな要因と考えられる。「箇条書きでまとめて」、「短く要約して」、「表にして」といった指示に、それまでの質問応答システム(6)の比ではない高い品質で、生成AIは従うことができる。生成AI以前のAI調査ツールはキーワードをベースとした従来の検索エンジンとUI上は大差なく、使用に一定のスキルが求められたことは否めない。自然文で検索できても、画面上の検索結果を読み解くという暗黙のITスキルは必要だった。それが生成AIを用いる場合、検索結果をもAIが要約した文章として表示される。ユーザはツールの使い方を学習する必要がないというわけである(図1)。

生成AIは基本的に、入力テキストを別のテキストへと変換あるいはその続きを出力するLLMという機械学習モデルを、質問応答に即するように訓練したものである。モデルは本来、訓練した際の情報にしか触れていないので、再学習させない限り新しい情報に基づいた応答は困難であるが、「大規模」であるLLMを再学習してモデル更新をするのは多大なコストがかかるので避けたい。ここでLLMは、入力されたテキストに新しい情報が含まれる場合、それをあたかもその場で学習したかのように応答できる(文脈内学習(7))ことから、Retrieval-augmented Generation(RAG)(8)という手法が考案された。ユーザが入力する質問文に、関連文書の中身を結合することで、その文書の内容を踏まえた応答をさせる。これにより、学習時に持ち得なかった新情報や、特定のドメインに特化した応答を、より高い精度で出力できるようになった。「検索できる生成AI」と呼ばれるものは、このRAGを組み込んでいる。当然、入力テキストに関連した文書を見つける検索部分の実装が重要であり、入力テキストから検索エンジン向けのキーワードを生成してから検索、入力テキストと意味的類似度が近い文書を言語処理技術で直接検出、といった方式がある。次節で紹介するような商用ツールでは、検索を繰り返して品質を向上しているような挙動もよく見られるが、その内部実装は当然非公開である。この点、学術文献データベースSemantic Scholarを提供するAi2社はRAGを用いた文献検索エンジンのオープン実装OpenScholarを公開(9)しており、業界スタンダードと思われるシステム構成と採用技術を窺い知ることができる。

3. 代表的なツール

執筆時点で注目を集めているツールを、主たる用途に着目して大きく2つに分類し、紹介する。なお、ほとんどのツールは英語での使用を前提としており、日本語でも一応の動作はするものの、公式にサポートされていないので、有用性に劣る点は注意が必要である。

3.1 検索・探索の支援

前述のような、検索結果を取り込んで生成AIが要約したり、その内容について質問応答(フォローアップ)したりできるツールが、商用レベルで多数リリースされている。

- Elicit(10):「Do clinical language models compromise patient privacy?」といった自然な疑問文で研究主題(Research Question:RQ)を入力すると、関連性の高い文献を検索したうえで、表形式にまとめて表示する。自動構築される表には各論文の要約や、核となる主張、調査・実験論文の場合はそのデータ統計などがカラム(列)として用いられる。全文がアクセス可能な論文に対し、生成AIで要約する作業を繰り返すことで実現しているとみられる。

- Consensus(11):RQを入力すると、それが支持されるかどうかに基づいて論文を整理する。検索結果の何%がRQを支持(Yes)するかがグラフィカルに表示され、生成AIが論文内容をもとにRQに回答するレポートも出力される。ただしデフォルトではトップ10記事のみを分析するので、実用上の注意が必要だろう。

- Scite Assistant(12):Sciteは文献が引用されている文脈に応じて文献検索できるサービスである。文献は肯定的にも否定的にも引用されうることから、本文中でどのように引用されているかに基づいて学術論文を分類した引用文脈データベースをScite社は構築している。Scite Assistantはその検索結果の要約や質問応答に生成AIを用いたものであり、文献のアカデミックな評判を調べるのに適している。

- Perplexity(Academic Focus)(13):ChatGPTに先んじて公開されていた検索エンジンで、LLMを用いた「対話形式の検索」を世に提案した最初期のサービスである。Perplexityは検索対象のドメインを絞り込むFocusという機能を提供しており、この選択肢の中に学術文献に特化したAcademicがある。

- Gemini Deep Research(14):2024年12月にGoogle社の生成AIであるGeminiに追加された機能で、学術文献に特化して調査し、複数ページものレポートを出力できる。RQを入力すると、Geminiはまず検索の計画を立て、ユーザに確認を求める。検索計画はチャット上で変更を指示できるほか、検索が実行されている間はどういったサイトを調査しているかリアルタイムで確認できる。Google社らしい連携として、生成されたレポートはGoogleドキュメントとして編集できる。

- GPTsで公開されている研究用途の“GPT”:OpenAI社のChatGPT(15)は、ユーザが独自のプロンプトやRAGシステムを設定したカスタム版のChatGPTを公開できるGPTsというプラットフォームを提供しており、この中に文献調査向けに調整されたものがいくつか見られる。個人も作成可能なので悪意あるものも流通しうるが、対話の中で何がどのように検索されるかは事前に表示されるので、プライバシーや機密の漏洩をユーザは防止できる。なお、ChatGPT本体にもWeb検索できる機能が追加されている。

3.2 読解の支援

論文記事を指定すると、その内容について要約したり質問したりできるツールもある。上記に挙げたツールにも同様の機能を有するものがあるが、ここに挙げるのはそれをメインとするものである。

- SciSpace(16):論文PDFをアップロードすると、PDFとチャット欄が縦2分割で表示され、論文内容について質問しながら本文を読み進められる。PDFビューワ側で本文や数式を選択すると、その要約や説明を要求できる。SciSpaceでは文献検索のほか、投稿規定に合わせた文献フォーマットの変更などのツールも多数提供されている。

- NotebookLM(17):Webページを指定したりPDFをアップロードしたりすると、それらの文書群について質問できるGoogle社のサービスである。学術文献に特化しているわけではないが、論文に対しても遜色なく動作する。生成AI(Gemini)の回答には文献の該当箇所に飛べるリンクが埋め込まれており、裏付けをとりやすい。

- Illuminate(18):執筆時点ではGoogle社のベータ版サービスだが、論文のURLやPDFを指定すると、その内容を15分程度のラジオ番組(あるいはポッドキャスト)風にまとめた音声データを出力する。同様の機能はNotebookLMにも搭載されているが、Illuminateは論文に特化し、番組の形式(話者の人数や専門性など)もより細かく設定できる。

4. 展望

4.1 ツール発展の方向性

直近で実現の可能性が高いのは、より複雑な調査を自動化することである。ショッピングサイトのような複雑なWebアプリを操作できるAIも各社から発表されている(19)(20)。プログラムから呼び出しやすい窓口(API)が用意されたデータベースだけが上記ツールの検索対象であったが、今後はAPI未整備の古いデータベースやWebサイトをも人間がブラウジングするように操作して情報収集できるようになる。PDF形式の表でしか統計データを公開していないような情報源に思い当たる読者も多いはずだ。サイトトップからページをたどってPDFファイルを見つけ、該当の表を探すといった一連の操作を自律的に実行するシステムも近いうちに使えるようになる。

もう一つは、研究業務そのものの自動化である。Sakana AI社による、機械学習分野の研究を自動遂行するAI(21)は話題となった。情報学分野では実験もコンピュータ上で行えるため早期に実現したと言える。今後、例えば生体を使った研究でも、コンピュータ経由での実験機器の自動操作が充実すれば展開可能と見られる。フィールドワークなどの対人調査についても将来、AIロボットとして身体を得た場合には不可能ではない。「人間がその手で実施する研究」が指す範囲が小さくなっていく中で、研究支援のあり方も変わるだろう。

4.2 研究支援業務での使いどころ

現在の生成AIツールは、言語モデルが保持する知識と、上位の検索結果たかだか数十件に基づいて、回答や要約を行う。職業研究者やレファレンスに長けた図書館員にとって、そのような調査が何を意味するかは明白である——実務においては無用の長物と思われる読者も少なくないだろう。実際、AI回答の正否と文献内容の照合に時間が取られるだけに見える。しかしそれは、伝統的な文献データベースをいかに検索し、得られた文献をいかに読み解けばよいか分かるという経験知があってこその認識だ。検索に使うべきキーワードや、内容を整理するための専門的観点がわからない未知の分野について調べるとき、伝統的なパスファインダー等のレファレンスツールでは成し得なかった形で糸口をつかめるようになったことは喜びたい。1パラグラフほどかけて説明した疑問について「それはXX学の専門用語でYYという現象ですね」という回答を得るためには、社会的資本が必要だった。上述のツールはこの体験を万人にもたらせる点で有意義である。しかし当然、生成AIによる滑らかな回答には「分かった気になる」ことを加速させる向きはあり、初学者ほど使用に注意を要するだろう。複数ツールの結果を比べる、確証バイアス(22)を避ける調べ方を学習しておくなど、生成AIベースかどうかによらず文献調査の際に留意すべき点は、引き続き押さえておく必要がある。

4.3 大学図書館員としての向き合い方

跋扈する生成AIツールが高等教育の現場に与える影響は大きく、各大学が使用の指針や注意喚起を発表しているところである。学内の研究支援や情報リテラシー教育を担う大学図書館は、教職員や学生に対してどのような情報提供をすべきだろうか。筆者が提案させていただけるならば、学内での利用が多いツールだけでも、その「安全性」について検証した結果をまとめてみてはどうかと思う。国内外の大学図書館が生成AIのユーザガイドを作成している例(23)は多く見られるが、概説的な使い方案内や一般的な注意喚起に留まっているように見受けられる。ここから一歩進んで、大学図書館員自らツールを使用しながら、次のような点を評価できないだろうか。

- 利用規約やプライバシーポリシーの安全性:生成AIに入力した未発表の研究アイデアが、ツール開発者や提供者に流出しかねないものもある。入力情報の著作権や、第三者への提供に関する規定はまちまちだ。例えば、東京のスタートアップが提供する生成AIベースの検索エンジンFelo Search(24)は研究利用を謳う新機能(25)も発表しているが、本稿執筆時点で同社の規約は送受信されうるユーザの研究データに対して何ら明確な姿勢を示していない。加えて、サービス利用と同時に適用されてしまう利用規約とプライバシーポリシーへのリンクは目立たない位置にある。小規模な会社の生成AIツールは法的整備の優先順位が低いこともあり、「新進気鋭」のツールに飛びつくのはリスクがある。

- ハルシネーション注意喚起の表示方式:生成AIを用いた文献調査ツールにおいても、いわゆるハルシネーション(誤情報の出力)が生じうる。ベースとなるLLMは理論的にハルシネーションを避けられないとする研究もある(26)。図1でも紹介したGoogle検索のAIサマリが、あろうことか誤情報を最上位に表示しうることは深刻に懸念されている(27)。上述のほとんどのツールでは「LLMは間違うのでソースを確認せよ」といった注意喚起が各所に表示されるが、その視認性や表示方法はまちまちなので、ユーザの視点から評価することは重要になる。例えばConsensusの場合、同様の注意喚起は、生成AIによる回答レポートの末尾に小さく表示されるボタンを押して初めて表示される。

- 調査時のバイアスへの対応:調査におけるバイアスの低減や自覚のためにシステマティックレビューのような文献調査手法が確立している。しかし本稿で紹介したツールは検索の網羅性が不透明なものも少なくない。既存の文献調査ガイドラインに照らしながら、実行された検索の詳細が表示されるか(図2)、回答に引用情報が含まれるか、引用元や原文を参照しやすいか(図3)といった観点から評価しなおすと良いだろう。

生成AIを用いた文献調査ツールの安全性に関するこれらの調査は、学術雑誌・出版社の著作権規定や信頼度を調査する既存の取り組みの延長にあたるとは言えないだろうか。当然、各ツールは頻繁にアップデートされるので、定期的な再評価が必要になるが、主なものに限れば現実的かと思われる。そのような動きがあれば筆者としてもぜひ応援・助力させていただきたい。

(1)LLM-jp et al. LLM-jp: A cross-organizational project for the research and development of fully open Japanese LLMs. arXiv. 2024, arXiv:2407.03963.

https://doi.org/10.48550/arXiv.2407.03963, (accessed 2025-01-17).

LLM 勉強会.

https://llm-jp.nii.ac.jp/, (参照 2025-01-27).

(2)森内泰. 文献調査に利用できる生成AI ツールと、その使われ方. 長崎県立大学論集 (経営学部・地域創造学部). 2023, 57(2), p. 19–30.

http://hdl.handle.net/10561/1967, (参照 2025-01-17).

(3)Carpineto, C.; Romano, G. A survey of automatic query expansion in information retrieval. ACM Computing Surveys. 2012, 44(1), p. 1–50.

(4)Nayak, P. “Understanding searches better than ever before”. Google The Keyword. 2019-10-25.

https://blog.google/products/search/search-language-understanding-bert. (accessed 2025-01-13).

(5)井上和仁, 川原綾, 藤井遥子, 大久保三四朗, 加藤真壽美. AIを活用した新しい医薬情報検索(JDream SRプロダクト・レビュー). 薬学図書館. 2022, 67(2), p. 69–73.

https://doi.org/10.11291/jpla.67.2_69, (参照 2025-01-17).

(6)2020年ごろの企業ホームページに見られたFAQチャットボットを思い出していただくと良い。

(7)Dong, Q. et al. “A survey on in-context learning”. Proceedings of the 2024 Conference on Empirical Methods in Natural Language Processing. Florida, 2024-11-12/16. Association for Computational Linguistics, 2024, p. 1107–1128.

(8)Gao, Y. et al. Retrieval-Augmented Generation for Large Language Models: A survey. arXiv. 2023, arXiv:2312.10997.

https://doi.org/10.48550/arXiv.2312.10997, (accessed 2025-01-17).

(9)Asai, A. “Ai2 OpenScholar: Scientific literature synthesis with retrieval-augmented language models”. Ai2. 2024-11-19.

https://allenai.org/blog/openscholar, (accessed 2025-01-13).

(10)Elicit.

https://elicit.com, (accessed 2025-01-17).

(11)Consensus.

https://consensus.app/, (accessed 2025-01-17).

(12)scite.

https://scite.ai/assistant, (accessed 2025-01-17).

(13)Perplexity.

https://www.perplexity.ai/, (accessed 2025-01-17).

(14)Citron, D. “Try Deep Research and our new experimental model in Gemini, your AI assistant”. Google The Keyword. 2024-12-11.

https://blog.google/products/gemini/google-gemini-deep-research/, (accessed 2025-01-17).

(15)ChatGPT.

https://chatgpt.com/, (accessed 2025-01-17).

(16)“Chat with PDF”. SCISPACE.

https://typeset.io/chat-pdf, (accessed 2025-01-17).

(17)NotebookLM.

https://notebooklm.google.com/, (accessed 2025-01-17).

(18)Illuminate.

https://illuminate.google.com/, (accessed 2025-01-17).

(19)Pichai, S. et al. “Introducing Gemini 2.0: our new AI model for the agentic era”. Google The Keyword. 2024-12-11.

https://blog.google/technology/google-deepmind/google-gemini-ai-update-december-2024/, (accessed 2025-01-13).

(20)Perplexity Team. “Shop like a Pro: Perplexity’s new AI-powered shopping assistant”. Perplexity Blog. 2024-11-18.

https://www.perplexity.ai/hub/blog/shop-like-a-pro, (accessed 2025-01-13).

(21)“「AIサイエンティスト」: AIが自ら研究する時代へ”. sakana.ai. 2024-08-13.

https://sakana.ai/ai-scientist-jp/, (参照 2025-01-13).

(22)当たりをつけられれば生成AIに頼るまでもないレベルの事例ではあるが、この心理学用語を見つける際のChatGPT使用例を、この小節の論旨に沿ったメタ的な例として紹介する。

ChatGPT.

https://chatgpt.com/share/6784b64e-82fc-800d-ba30-027dcfaab94f, (accessed 2025-01-17).

(23)Harvard Library. “Artificial Intelligence for Research and Scholarship”. Research Guides.

https://guides.library.harvard.edu/c.php?g=1330621&p=9798082, (accessed 2025-01-13).

(24)Felo.

https://felo.ai/search, (accessed 2025-01-17).

(25)Felo Search Tips Buddy. “How Felo 3.0 Search Agent Can Revolutionize Your Academic Research”. Felo Search. 2025-01-11.

https://felo.ai/blog/search-agent-academic-research/, (accessed 2025-01-14).

(26)Banerjee, S.; Agarwal, A.; Singla, S. LLMs Will Always Hallucinate, and We Need to Live With This. arXiv. 2024, arXiv:2409.05746.

https://doi.org/10.48550/arXiv.2409.05746, (accessed 2025-01-17).

(27)“検索結果の概要を自動生成する「AI Overviews」が“誤情報”を表示、グーグルが認めた問題の中身”. WIRED. 2024-06-01.

https://wired.jp/article/google-ai-overview-search-issues/, (参照 2025-01-13).

[受理:2025-02-10]

矢田竣太郎. 動向レビュー:生成AIを用いた文献調査ツール. カレントアウェアネス. 2024, (362), CA2079, p. 6-10.

https://current.ndl.go.jp/ca2079

DOI:

https://doi.org/10.11501/14120733

Yada Shuntaro

Literature Review Tools Using Generative AI